폐쇄망·제한된 GPU·보안 규정. 어떤 제약 환경이든 실제 운영 가능성을 검증하고, 도입부터 운영까지 함께합니다.

대부분의 기업이 같은 문제로 LLM 도입을 망설입니다.

예산은 한정적인데, 모델은 점점 커지고 GPU는 부족합니다. 결국 비효율적인 SaaS에 의존하게 됩니다.

사내 데이터를 외부로 보낼 수 없는 환경. 온프레미스에서 직접 운영해야 하지만 전문 인력이 부족합니다.

동시 사용자가 늘어나면 응답 시간이 급격히 증가합니다. 사용자 불만이 곧 도입 실패로 이어집니다.

※ 담당자에게 자료 받아서 보강할 예정입니다. 해당 프로젝트에 대한 자세한 정보 받아서 업데이트 예정입니다.

SE Asia

검증된 엔터프라이즈 운영 노하우를 그대로 귀사에 적용합니다. 폐쇄망 환경에서도 안정적인 성능을 보장하는 실전 검증 사례입니다.

1억+ 가입자 기반 인프라

On-Premise LLM 운영

Korea

(가상 사례) 금융·보안 규제가 엄격한 환경에서 온프레미스 LLM 운영을 성공적으로 구축한 사례. 실제 사례로 교체 예정입니다.

대규모 온프레미스 · 보안 인증

다중 모델 · 저지연 운영

Japan

(가상 사례) 대량 트래픽 환경에서 동적 배칭·스케일링으로 안정적인 서비스를 제공한 사례. 실제 사례로 교체 예정입니다.

고가용성 · 자동 스케일링

멀티테넌트 · 비용 최적화

※ 한국·일본 사례는 가상 사례이며, 실제 사례로 교체 예정입니다.

실제 운영 데이터 기반의 성능 지표와 아키텍처를 직접 확인하세요.

클릭하면 라이브 대시보드로 이동합니다

전체 기능 • 실시간 데이터 • 인터랙티브 차트

Preview only - Click below for full interactive dashboard

Launch Full DashboardFull interactivity • Live data • All metrics

동시 접속자 수에 따른 응답 속도 비교 (ms)

// 독자적인 vLLM 최적화로 동접 50명 상황에서도 Latency 200ms 미만 유지.

Production Architecture Overview

User Request

API / WebSocket

Smart Router

Load Balancing

Autoscaling vLLM

Dynamic Batching

Shared KV Cache

Memory Pool

검증된 데이터 기반의 의사결정으로 도입 리스크를 최소화합니다.

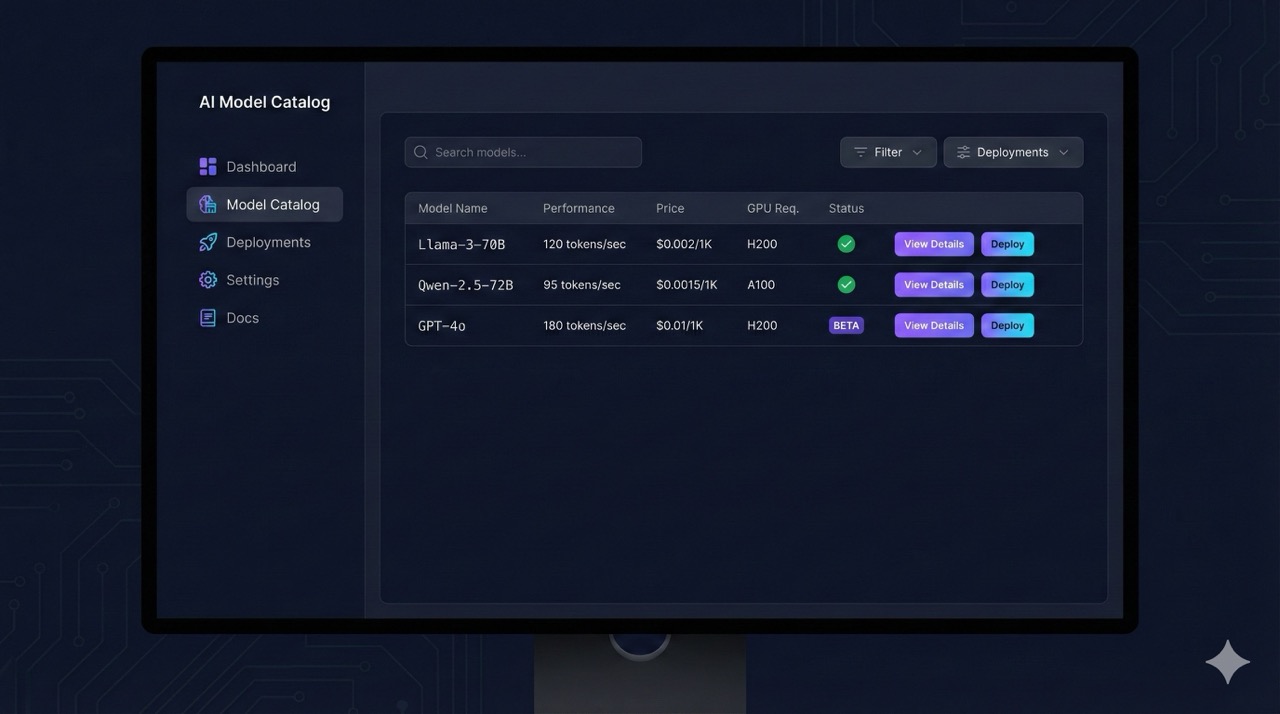

마치 식당 메뉴판처럼, 어떤 AI 모델이 어디에 강하고 운영비는 얼마인지 정리해둔 데이터베이스입니다.

고객이 AI를 쓰기 전에 '이 정도로 쓰면 속도가 얼마나 나올까?'를 미리 테스트해보는 가상 환경입니다.

AI가 실제 서비스될 때 어디가 아픈지, 어디를 고치면 더 빨라질지 실시간으로 지켜보는 현미경 같은 시스템입니다.

체계적인 4단계 프로세스로 안정적인 LLM 운영 환경을 구축합니다.

GPU/인프라/목표 분석

최적 모델 조합 & 성능 예측

맞춤형 파이프라인 설치

실시간 성능 관리

전문 엔지니어가 24시간 내에 답변드립니다.

귀사의 비즈니스에 맞는 최적의 LLM 운영 전략을 제안해 드립니다.

문의가 성공적으로 접수되었습니다.